恭喜他们!在INTERSPEECH 2022 会议场景的非侵入式客观语音质量评估挑战赛中获胜

2022年4月1日

学术活动本届大赛由腾讯会议旗下腾讯天籁实验室联合柏林工业大学、印第安纳大学布卢明顿分校、南方科技大学、西安电子科技大学的教授们以及微软主办,共吸引了来自中国,比利时,美国,韩国,巴基斯坦,瑞士,爱尔兰,印度,德国,加拿大等10个国家及地区的学术界和工业界团队报名,竞争激烈。

挑战赛的目的

随着在线会议等语音通信系统的进步,无论人们身在何处都可以无缝地与他人合作。然而,在线会议场景中,语音质量会受到背景噪声、混响、丢包、网络抖动等的显著影响,影响通话质量。如果能线上监控语音质量并及时与服务提供商共享统计信息。这使服务提供商能够找出根本原因并提高语音质量,以保证未来更好的用户体验。根据ITU-T P.800,语音质量评估需要在实验室环境中进行主观评估。然而,这些方法成本高昂,不能应用于线上会议中。因此,需要一种有效的客观评估方法来评估或监控正在进行对话的语音质量。

挑战赛任务

此次大赛仅设置了一个任务:会议场景的非侵入式的客观语音质量评估任务。为此,此次挑战赛开源了一个包含主观质量分数的语料库,总计超过 86,000 条。其中,涵盖了实时语音通信过程可能遭受的各种语音质量损伤场景。我们希望参赛队伍通过所提供的数据集设计相应的算法评估语音质量以达到更接近人主观感受的目的。此次挑战赛关注于前沿算法研究,不设置任何算法限制。

挑战赛评价准则

在此次挑战中,我们计算了均方根误差 (root mean squared error,RMSE) 和 RMSE_MAP来评估准确性以及皮尔逊相关系数 (pearson correlation coefficient,PCC)来评估线性相关性。挑战赛的最终排名由RMSE_MAP来确定。其中:

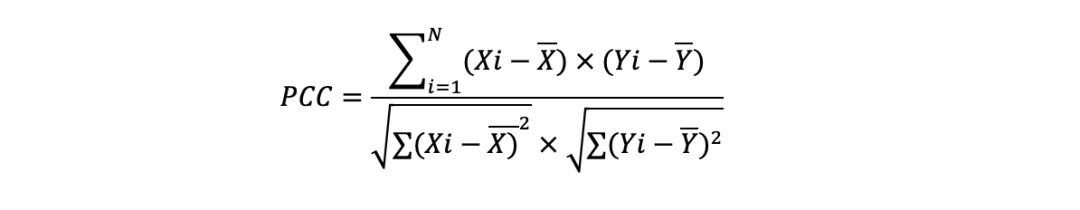

- PCC:衡量模型的预测分数与主观分数之间的线性关系。可以通过以下公式获得:

其中 Xi 表示主观分数 MOS,Yi 表示预测的客观分数 (MOSp)。N 表示测试数据集的语音样本总数。

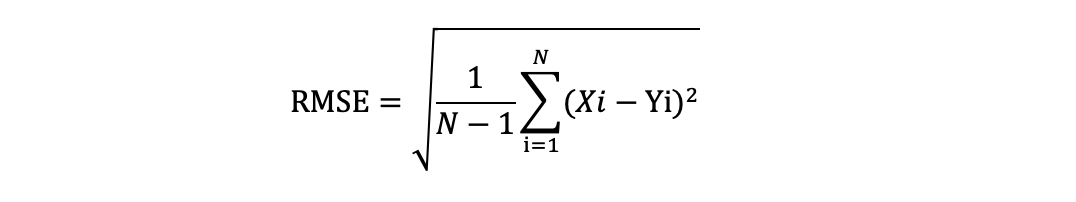

- RMSE:评估模型的预测分数与主观分数之间的准确性。可以通过以下方式获得

- RMSE_MAP:由于偏差或偏移,不同的梯度以及不同的定性等级顺序总是存在于主观评价中。收集的 MOS 分总是存在统计的不确定性。因此,此次挑战赛用三阶多项式函数来补偿几个主观实验之间可能存在的差异。对于每个模型,我们为每个测试数据集创建一个映射函数。然后使用映射之后的预测分数以及主观分数来计算 RMSE_MAP。

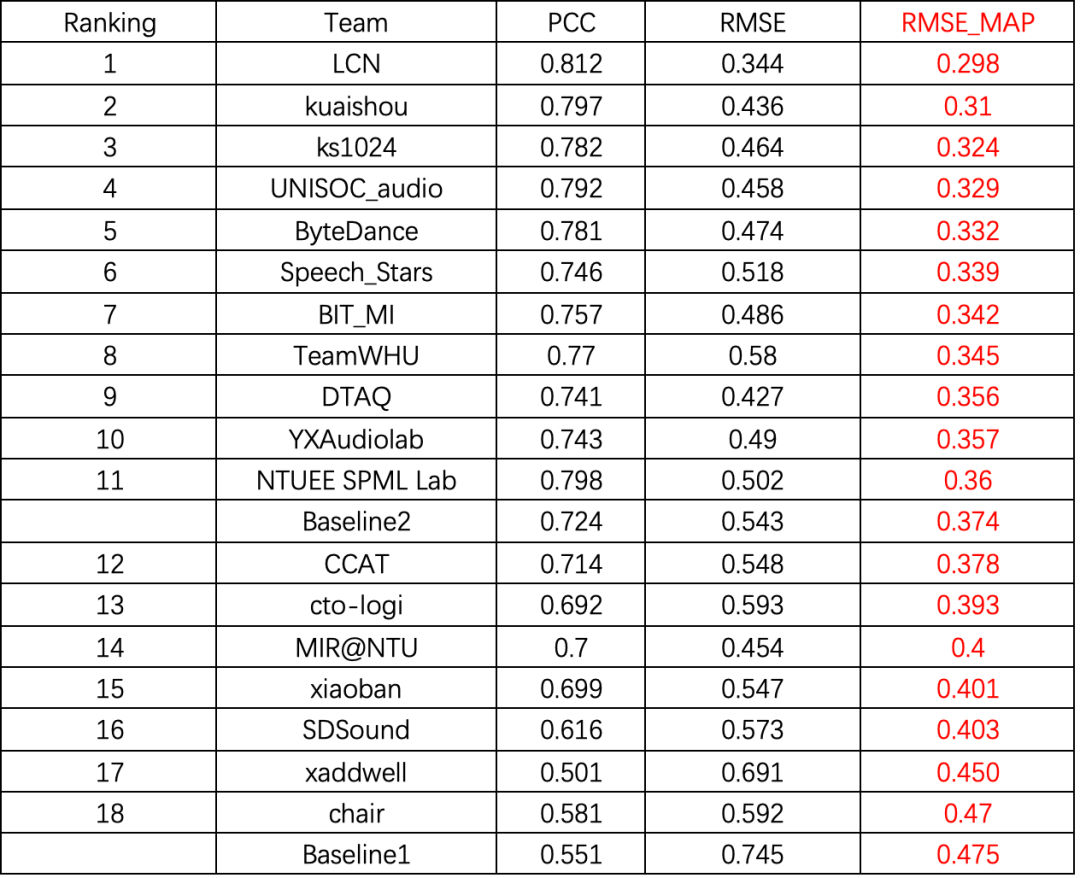

比赛结果

经过近4个月的组织实施,竞赛任务的奖项已产生。其中比利时鲁汶大学团队取得了本次竞赛任务的第一名,来自于北京快手科技有限公司的两个团队分别获取本次竞赛任务的第二名与第三名。

本次挑战赛所有队伍的最终排名如下:

感谢众多报名团队的热情参与,恭喜获胜团队!了解更多比赛详情,欢迎访问活动官网。